위 사진 속에 있는 인물들 중 실존 인물은 과연 누구일까?

얼마 전 그래픽 처리 장치 전문업체 엔비디아(NVIDIA)가 ‘인공지능(AI)를 활용해 실존하지 않는 인물을 사진으로 만드는 기술’을 담은 연구논문을 밝혔다.

어떤 사람이 진짜이고 누가 가짜인지 육안으로는 거의 판별이 불가능한 사진 속 인물들은 놀랍게도 모두 실존하지 않는 사람들이다.

이러한 가짜 사진들은 여태껏 주로 포토샵을 통해 만들어졌지만 시간이 오래 걸리고 어느정도 육안으로 판별할 수 있기도 했다.

그러나 AI의 현저한 발달로 인해 더이상 진짜와 가짜의 사진을 식별하는 자체가 거의 불가능한 상황이 된 것이다.

엔비디아 연구진들은 논문을 통해 “실제 사람 얼굴 특징을 뽑아내서 이를 혼합하는 알고리즘을 개발했다”며 “생성적 적대 네트워크(Generative Adversarial Networks)를 활용해서 현실에서 볼 수 있을 법한 얼굴로 맞춤화했다”고 전했다.

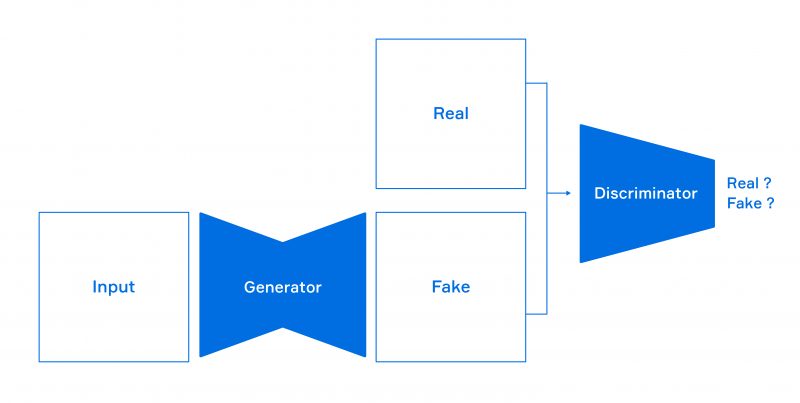

꽤나 낯선 용어인 ‘생성적 적대 네트워크’는 최근 몇 년 사이에 AI 네트워크 분야에서 가장 주목받는 기술이다.

이는 서로 경쟁하는 네트워크를 구성해 결과를 지속적으로 비교해 상호학습을 하도록 만드는 것이다.

즉 쉽게 이야기하자면 한쪽은 계속적으로 정교한 가짜 사진을 생산해내고 다른 한쪽은 이러한 사진이 가짜인지 판별해 계속적으로 경쟁하도록 만들어 최고의 결과물을 얻어내는 것이다.

엔비디아 측은 사진 공유사이트에 올라온 약 7만 장의 인물 사진을 이용해 두 AI 네트워크를 훈련하고 학습시켰다.

연구진은 “이번에 공개한 가짜 사진은 어떠한 ‘생성적 적대 네트워크’로 만든 것보다 우수하다”며

“모자, 선글라스, 안경 등도 감지해서 재현할 수 있고 완전히 새로운 사람의 모습을 무한대로 생성해낼 수도 있다”고 전했다.

뿐만 아니라 “사람에서 끝이 아니라 동물, 침대와 같은 사물도 이러한 방법을 이용해 만들어낼 수 있다”고 말했다.

그런데 이러한 놀라운 기술의 발전에 감탄하는 것이 끝이 아니라 부작용도 심각히 생각해볼 필요가 있다.

유명인의 사진을 남용해 이미지에 타격을 주는 사진이나 영상을 만들어낼 수도 있기 때문이다.

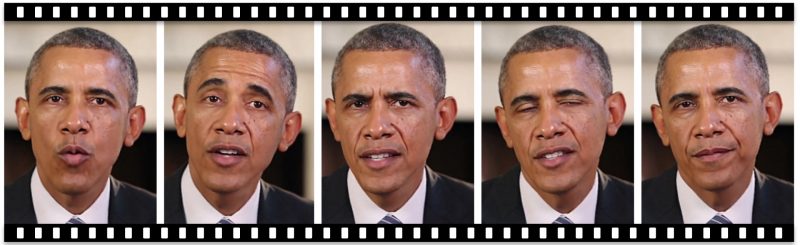

유명 여배우들의 얼굴을 성인물에 합성하는 행위나 정치인들이 가짜 뉴스의 주인공이 되는 일들이 더욱 비일비재해질 수 있다는 이야기이다.

실제로 2018년 7월 미국 워싱턴 대학 연구진은 ‘인공지능’을 활용해 감쪽같이 만든 오바마 전 대통령의 가짜 영상을 공개한 적이 있다.